Eure Vital-Metriken verändern sich offenbar willkürlich. Ruft man z.B. immer ein und dieselbe URL via API im Abstand von zehn Sekunden auf, erhält man einen Score-Wert von 40 bis 80 (von jeweils 100). Man muss nur lange genug abrufen, dann erhält man früher oder später einen Wert, der von Gelb auf Grün oder von Rot auf Gelb springt. Die Metriken sind für den normalen Webbetreiber und auch für Experten nicht transparent oder durchschaubar!

Im Januar dieses Jahres hat Google über https://web.dev/better-layout-shift-metric/ zu Feedback aufgerufen, weil die Berechnung des CLS-Wertes wohl diverse Probleme macht. Reichlich spät für eine im Mai (!) angekündigte Verwendung für das Ranking. Die neueste Verlautbarung ist nun, dass die Auswirkungen der Core Vitals nur sehr gering ausfallen werden und weiterhin die Qualität des Inhalts dominant wichtig sei.

Also same procedere as every year? Wie damals bei HTTPS, Speed, und Mobil? Starker Druck über die Ankündigung als Rankingfaktor, Verlängerung der Einführung als Rankingfaktor, dann Abmilderungsaussagen bezüglich der Wirkung und am Ende nach dem Eingang in die Bewertung: Nichts oder fast nichts zu spüren? Wir müssen es uns fast wünschen!

Zum einen sind die Werte der Vitals objektiv gesehen noch immer zu transparent, volatil und machen keinen vertrauenserweckenden Eindruck. Wie soll man optimieren und prüfen, ob und was man erreicht hat, wenn die Werte so krass schwanken? Wenn es Zufall ist, zu welcher Tagessekunde man auf den Button „Analyse“ drückt?

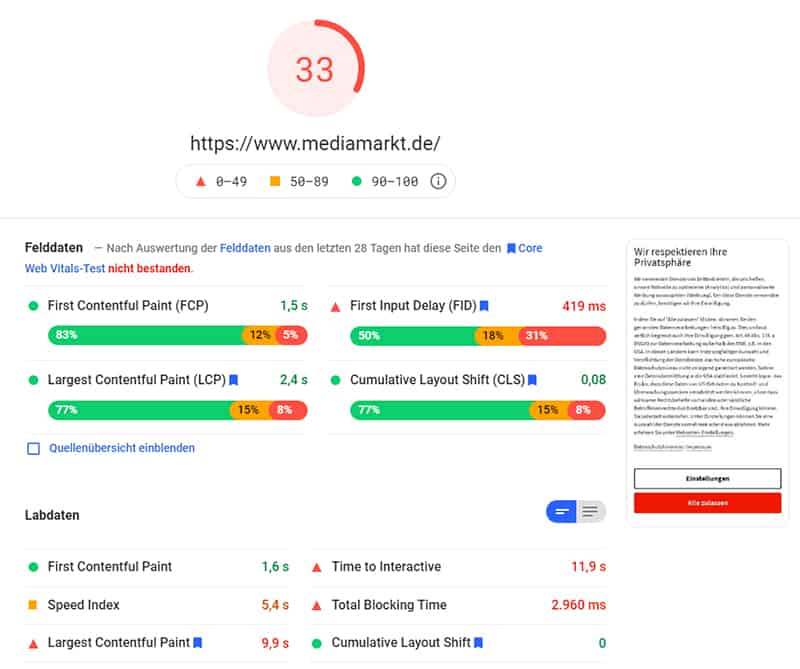

Wenn durch bloßes Betrachten einer Seite Werte im Browser entstehen können, die jeden gemittelten Wert spürbar hin zum Schlechteren schieben können und oft in absurde Höhen? Darf man Googles Messungen vertrauen, wenn sie über 16 Sekunden Ladezeit für ein Element (allerdings das größte) der Seite herauskalkulieren und den Gesamtindexwert pro Klick von 15 auf über das Doppelte auf 33 innerhalb von nur drei Minuten hin und her schwankt? Selbst MediaMarkt besteht den Core-Web-Vital-Test nicht.

Wie soll Kalle Klein mit seinem Shop je besser sein als diese Verkaufsgiganten mit ihren Armeen von Systemtechnikern? Langsam, aber sicher gehen einem die Möglichkeiten aus, noch Begeisterung zu zeigen. Man fühlt sich, als müsste man ein chinesisches Kreuzworträtsel lösen, während man gleichzeitig von einem Tiger gefressen wird.

Natürlich muss und sollte man es im Sinne der Webnutzer begrüßen, wenn zu langsame Webseiten schneller werden, unnütze „Unser-Firmengebäude“-Slider verschwinden, bei denen sich der Augapfel freiwillig kompostieren möchte, Bildschirmelemente nicht wild hin und her hüpfen oder es nach einem Klick auf ein Element eine gefühlte Ewigkeit dauert, bis die Seite reagiert. Wenn manche CSS-Datei oder Monster-JavaScript-Dateien die u.a. auch zum Sprengen von U‑Bahn-Tunneln verwendet werden, endlich entschlackt werden. Die derzeit aber halb gar wirkenden Vorgabewerte sind leider so gestaltet, dass man bei tiefroten Messwerten und einem kontrollierenden Aufruf der Webseite über das Handy dort eben keinerlei echte Hindernisse bemerken kann. Sollen wir unsere Webseiten etwa so verbiegen, dass Google „richtig“ rechnen kann?

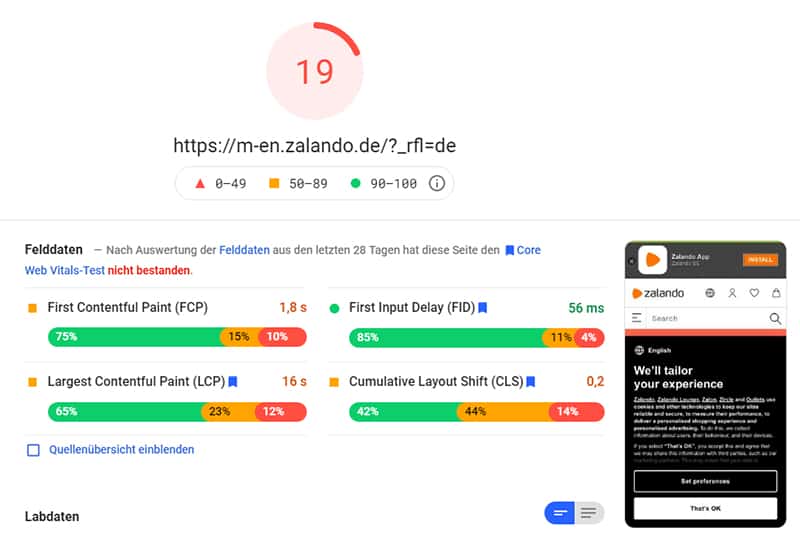

Hat jemand tatsächlich beim Aufruf von zalando.de mehr als 16 Sekunden gewartet? Laut der Berechnung von Google scheint die Webtechnik von Zalando eher einem YPS-Heft entnommen worden zu sein, statt einer sicherlich wohlüberwachten Systemtechnik.

Man kann nur hoffen, dass Google hier ein Einsehen für die Sorgen der Verantwortlichen hat, nacharbeitet, mehr erklärt und vor allem stabilere, zuverlässige und plausible Messwerte zur Verfügung stellt. Entweder haben sie diese verlässlichen Werte schon jetzt vorliegen – dann bitte her damit. Oder sie haben eben keine (siehe dieser Beitrag) – und dann haben diese Metriken zumindest beim vorliegenden, von außen erkennbarem Sachstand noch lange nichts in den Rankingalgorithmen verloren. Auch nicht bei „nur wenig Auswirkungen“, denn eine Verschlechterung um auch nur eine Position beim Ranking kann je nach Keyword, Branche und den Umständen für die Betroffenen bereits Umsatzeinbrüche bedeuten. Und auch eine kontrovers diskutiere Kennzeichnung/Hervorhebung von Ergebnissen, die den Test bestanden haben, beeinflusst natürlich die Klickentscheidung der Suchenden. Wir reden also über echtes Geld, das durch halb gar wirkende Messungen durch Google seit Mai einfach „umverteilt“ wird.

Am 10.03. dieses Jahres verkündete Johannes Henkel von Google in einem Forum übrigens die neuesten Zahlen.

Er schreibt:

- 47,99 % of origins had good LCP

– 89,46 % of origins had good FID

– 45,99 % of origins had good CLS

– 21,98 % of origins had good LCP, FID and CLS

Nicht einmal 22 % aller gemessen Webseiten haben also Googles neuen Messwert-Test bestanden! Aber bis Mai ist ja auch noch viel Zeit. <Ironiemodus:aus>. Ach ne.. Ist ja schon Juni. Na dann …